Ceci est la traduction d'un billet de Lubos Motls

The Reference Frame: Weather, climate, and noiseGavin Schmidt et Stefan Rahmstorf discutent sur realclimatdotorg [la bible de la très sainte église du rechauffisme] des différences entre météo et climat. On y trouve de bonnes choses mais aussi beaucoup de naïveté.

Ils présentent les températures observées comme la somme d'une tendance de fond - tendance sensée représenter le climat probablement due pour une large partie aux gaz a effet de serre - plus un bruit aléatoire, i.e la météo. La météo représente le court terme mais ses effets sont sensés disparaitre en moyennant sur une période suffisamment longue. Selon eux cette période ou l'on commence a entrevoir les tendances du climat est de 15 ans.

Cette approche est intéressante pour avoir une idée simpliste a propos de la météo, du climat, et des différences entre les deux, mais leur modèle naïf est clairement insuffisant pour comprendre la climatologie du 20 siècle. Il y a beaucoup de raisons, certaines d'entre elles sont liées - regardons cela plus en détail.

1. Les changements du climatiques ne sont pas le résultats d'un seul effet, comme ils [gavin et compagnie] semblent le suggérer, mais plutôt d'une centaine d'effets qui agissent a différentes échelles de temps i.e de quelques secondes a quelques milliards d'années.

2. Ces effets a long terme ne conduisent pas a une variation linéaire de la température ou de tous autres paramètres climatiques. Bien au contraire, beaucoup d'effets a long terme oscillent ou sont périodiques.

3. Il n'y a pas de démarcation franche entre le court terme et le long terme. Choisir une telle limite ne peut être qu'une pure convention [i.e arbitraire]. Vous devez toujours avoir a l'œil qu'il existe des facteurs qui ont une influence rapide et d'autres une influence lente.

4. Pour tous les animaux, hommes ou nations, c'est la météo locale qui importe. Les températures locales sont beaucoup plus aléatoire que les variables globales moyennes. Ceci qui signifie bien que les variations locales sont plus importantes - pour nous qui les subissons - que les variations moyennes a long terme - que personnes ne subit. Ces variations long terme sont par conséquent plus intéressantes pour les spécialistes, ou les bureaucrates arrivistes, qu'elles ne le sont pour le décideur raisonnable ou l'homme ordinaire.

5. Les moyennes sur les échelles de temps et d'espaces peuvent augmenter le ratio signal/bruit, mais ces moyennes ne sont jamais parfaites. Les changements observés sur une période longue, disons un siècle, peuvent toujours faire ressortir des tendances qui ne semblent pas être le résultat d'un aléa météo.

6. Moyenner sur des échelles d'espaces plus petites que la surface de la terre et des échelles de temps plus petite qu'un siècle peut être suffisant pour supprimer les aléa météo. Ceci signifie que des désaccords, sur des continents lors d'une période de trente ans, entre la réalité

observable et les modèles peuvent remettre en cause les conclusions de ces modèles

7. Quand ils parlent des aléa météo, ils imaginent clairement quelque chose de non corrélé, i.e les anomalies d'une journée ne sont pas corrélées avec les anomalies de la veille. (De même que d'une année sur l'autre). En réalité, les aléa météo sont toujours corrélés en fonction de l'échelle de temps choisi. Il donc est important de connaitre la nature de ces aléa.

8. Ils pensent que les tendances et les aléa météo peuvent être tout simplement ajoutés. Cependant, ce genre d'hypothèse de linéarité n'est pas très pertinent dans la nature, en particulier a cause du caractère spécial des aléa météo, lesquels peuvent changer justement, en fonction des variations climatiques. Du coup il devient très difficile de séparer météo et climat.

Laissez moi maintenant vous expliquez plus précisément les différents points soulevés.

Les échelles de temps.La façon dont gavin smith voit la réalité est particulièrement simpliste: pour lui la température est la somme d'une tendance sous jacente, i.e le climat, une variation grossièrement linéaire due au CO2, et des aléa météo. D'ailleurs il ne s'intéresse pas a la météo et pense qu'il n'a même pas besoin de la comprendre. Je reviendrai sur cette assertion plus tard. Du coup lorsqu'il nous fait le coup des moyennes, il prétend s'affranchir de la météo et ainsi conserver la tendance de fond, le climat.

Mais ce n'est pas le résultat que l'on observe dans la nature. Même en supprimant tous les effets court terme, inférieurs a 15 ans, vous ne vous retrouverez pas avec une variation linéaire. En effet, aussi bien les observations qu'une bonne analyse théorique montrent qu'il y a plein d'autres choses.

La plus part des effets sont oscillatoires, et non monotones.L'activité solaire oscille selon des cycles de 11 années lesquels sont modulés par d'autres cycles de 200 années. Les courants marins amènent périodiquement des eaux chaudes et froides en divers endroits, selon des cycles variant de plusieurs années a plusieurs millénaires

Ajoutez a cela, les cycles de Milankovitch, la dérive des continents, les rayons cosmiques qui influent sur la météo [formations des nuages notamment] , ou les soubresauts de l'activité solaires. Tous ces facteurs sont importants. La température est donc le résultat d'effets linéaires, cycliques, chaotiques, imprévisibles ou calculables.

Même si vous faites l'hypothèse que la concentration en CO2 est le paramètre le plus important a observer, ces variations passées ont été largement influencé par le dégazage des océans (ce dernier est passe de 180 ppm a 280 ppm puis re a 180 ppm etc...) et sa concentration future sera elle aussi largement influencée par les changements technologiques ou le succès des fanatiques qui pensent pouvoir contrôler la vie des hommes. Les fonctions linéaires ne sont donc vraiment pas pertinentes.

Il n'y a pas de frontières claires entre climat et météoLes Gentlemans de RealClimatedotorg essaient implicitement de convaincre leurs lecteurs que 15 années est un intervalle de temps suffisant pour faire une distinction climat-météo. Mais il est évident qu'une telle limite n'est rien d'autre qu'une pure convention. De plus cette convention n'est même pas, celle couramment utilisée par les scientifiques du climat, lesquels utilisent plutôt 30 années.

De telles frontières seraient utiles s'il existait une échelle de temps capable de faire disparaitre certaines complications de la météo. Par exemple il n'est pas vrai que les température ne sont pas corrélées d'une année sur l'autre.

Je vais vous expliquez pourquoi. La météo n'est pas simplement quelque chose qui change d'une semaine a l'autre. La météo est aussi assujettie a des phénomènes tels que EL nino ou EL nina, et les météorologistes s'y intéressent. La durée moyenne du phénomène El nino est d'environ 2 années. Du coup il est évident que les influences d'El Nino se répercuteront l'année suivante. Si vous n'êtes pas d'accord avec cette conclusion car vous pensez qu'El Nino varie selon une autre fréquence, alors nous pouvons regarder l'oscillation décennal du pacifique qui influence également la météo, mais dont la fréquence varie de 10 a 50 années.

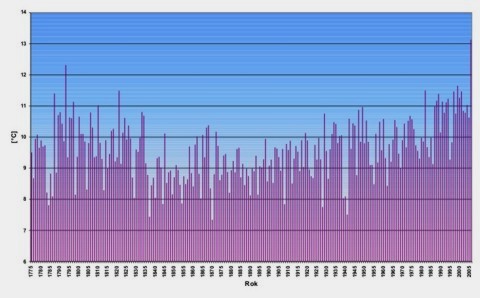

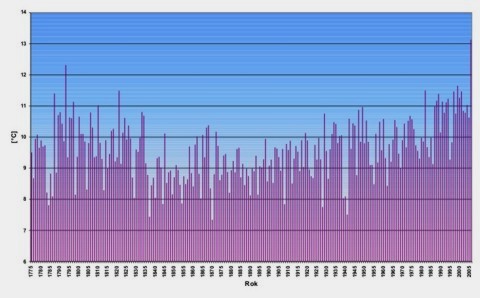

La meteo est plus importante que le climat.Les intervenants de RealClimat affirment avec raison que les variations des températures locales sont plus significatives que les variations de la température moyenne globale. Regardez un graphe des températures moyenne. Il semble évident qu'il ne s'agit pas d'une variation linéaire. Mais si vous vous intéressez aux habitants de Prague, vous conviendrez qu'ils sont sous l'influence de leur température locale et depuis 1775 voici de quoi cela a l'air:

La fin du 18ieme siècle est plutôt chaude, le 19 siècle est plutôt froid mais de nouveau le 20ieme siècle est chaud. Le graphe montre les variations des températures annuelles mais franchement les personnes réelles vivent dans le monde réel et sont influencés par les températures journalières. Et ces températures varient de 5C entre le jour et la nuit et de 10 a 20 C entre l'hiver et l'été. De même la température moyenne globale est plus chaude en été qu'en hiver d'environ

4 °C De plus en raison de l'asymétrie de la répartition des terres entre l'hémisphère nord et l'hémisphère sud, les saisons sont plus marquées au nord qu'au sud. L'eau réduit la vitesse de variation des température, [c'est l'effet thermostat, ou pourquoi en schématisant il fait toujours 15C en Bretagne.] )

Du coup en regardant les graphes, il semble évident que l'augmentation de 0.3C sur 50 ans moyennée a 10 années n'a pas la moindre influence sur la vie des habitants de Prague en comparaison des variations locales. De plus comme cette tendance moyenne a l'augmentation est globale, elle n'a aucune espèce d'importance face aux tendances locales comme a Prague ou partout ailleurs dans le monde et ceci pour chaque petit village.Il n'existe personne vivant dans ces moyennes tout comme il n'existe pas de personnes globales.

Les tendances moyennes ne sont jamais parfaitesN'importe quel imbécile qui trouve une corrélation entre x et y, pense avoir trouvé une preuve de l'existence de Dieu ou d'un phénomène naturel. Quelques scientifiques alarmistes aiment utiliser ce genre d'argument.Mais dans la réalité le coefficient de corrélation n'est jamais nul. Même si les données sont aléatoires et non corrélées, ce coefficient ne peut jamais être égale a zéro pour une série finie de points. Mais derrière le bruit, il peut aussi y avoir des contributions basses fréquences difficiles a prévoir tel que l'oscillation pacifique dont j'ai touché deux mot précédemment. Vous êtes en effet toujours assuré de voir des tendances positives ou négatives sur n'importe quelle série de données de température. Obtenir exactement zéro est très improbable avec une régression linéaire. Ainsi obtenir un résultat non nul - ou une série de résultat - ne peut constituer une preuve raisonnable pour s'alarmer.

Les continents et le moyen termeLes champions de l'hystérie climatique aiment affirmer que le moindre désaccord entre leur modèle et la réalité est due aux aléa météo. Par exemple, la masse de glace sur l'antarctique a augmente récemment. Certains alarmistes vont ainsi vous dire qu'il ne s'agit juste que d'une fluctuation, pendant que d'autres vous diront qu'ils l'avaient prédit dans leur meilleur modèle.

Ces réponses sont parfaitement contradictoires mais vous ne les verrez pas débattre pour essayer de les réconcilier. Pourquoi? Parce que ils se moquent bien de la réalité scientifique. Ils s'occupent de la promotion de leur politique favorite de régulation.

Dans la réalité, l'antarctique est une région très large et 30 ans est une période assez longue pour que les modèles qui prétendent parfois déterminer la politique a suivre pour l'année 2068, puissent prédire des tendances intéressantes. Si les modeles ne le peuvent pas alors vous aurez beaucoup de mal a convaincre une personne rationnelle que lorsque l'on passe sur la terre entière toutes les erreurs s'évaporent. Alors effectivement la chute dans la marge d'erreur relative est de l'ordre de racine de 2 mais en aucun cas nous passons d'une situation "tous ces effets sont dus a la météo et il n'y a donc pas de raison de se mettre d'accord" a la situation "tout est parfaitement précis , fiable et tout le monde doit etre d'accord".

Plus les régions sont petites et plus l'influence des aléa météo se fait sentir. Par exemple la fonte spectaculaire de glace de l'artique est un phénomène météo [tout comme sa reglaciation tout aussi extraordinaire]. Mais de toute façon nous n'avons pas besoin d'en parler, observons plutôt que durant ces 30 dernières années l'hémisphère sud c'est réchauffé (de 0.3C) trois fois moins vite que l'hémisphère nord. Ce qui signifie qu'en prenant des régions de l'ordre de grandeur de la terre entière - en fait la moitie - et des échelles de temps de 30 ans, le bruit est aussi important que le signal lui même, et ceci en prenant comme hypothèse qu'il y a bien un signal a la hausse des température. Ce bruit reste donc présent sur une grande échelle de temps et d'espace. Quand au bruit a Prague - comme partout ailleurs, il est encore plus important. La tendance au réchauffement est donc parfaitement négligeable. Bref, ce qui importe pour un être humain du monde réel c'est la météo locale

De quel type de bruit parle-ton?Schmidt et Rahmstorf, tout comme beaucoup d'autres, pensent la météo comme a un bruit blanc (pas de corrélation). Les anomalies de température du dimanche ont la même probabilité d'être positives ou négatives sans rapport aucun avec les anomalies des températures du samedi. Ou alors que anomalies des température de l'année 2008 peuvent être négatives ou positives indifféremment des anomalies de 2007. Mais comme nous l'avons explique, ceci est faux.

En fait les différences de température sur une petite échelle de temps ont de grandes chances d'être petites car la température est une fonction continue du temps.

Le mauvais découplage entre climat et meteoPour finir, les idéologues de realclimat.org aiment présenter les tendances du climat et la météo comme deux choses non corrélées: les observations sont simplement la somme de ces deux termes. Cette idée de linearite est la première chose que nous avons regarde, mais il existe de bonnes raisons de penser que cette approximation est mauvaise. Par exemple le réchauffement observe pendant les nuits et l'hiver semble plus rapide que pendant le jour et l'été. Soit dit en passant si vous faites

fleurir des orchidées vous vous moquez des températures nocturnes, du coup vous ne serez pas trop affecte par le réchauffement ;-). Enfin voila des exemples de non linearite. De plus ces observations conduisent a douter d'autant plus du réchauffement du au CO2, car celui-ci agit jour et nuit, 365 jours sur 365 jours.

Pour conclure si l'hypothèse de linearite est un point de départ intéressant, un scientifique ne doit pas cependant oublier qu'une hypothèse se vérifie, car elle peut être fausse. Il faut donc contrôler tous les détails et ne pas se satisfaire du prêt a penser des Gavin Schmidt.

Affaire a suivre dans un prochain billet sur les volcans et le climat.